Блог сканеры: Сканеры — Онлайн-касса.ru

Содержание

Сканеры — Онлайн-касса.ru

- #Маркетплейсы

- #Сканеры

Как выбрать сканер для Озона, Wildberries и других маркетплейсов

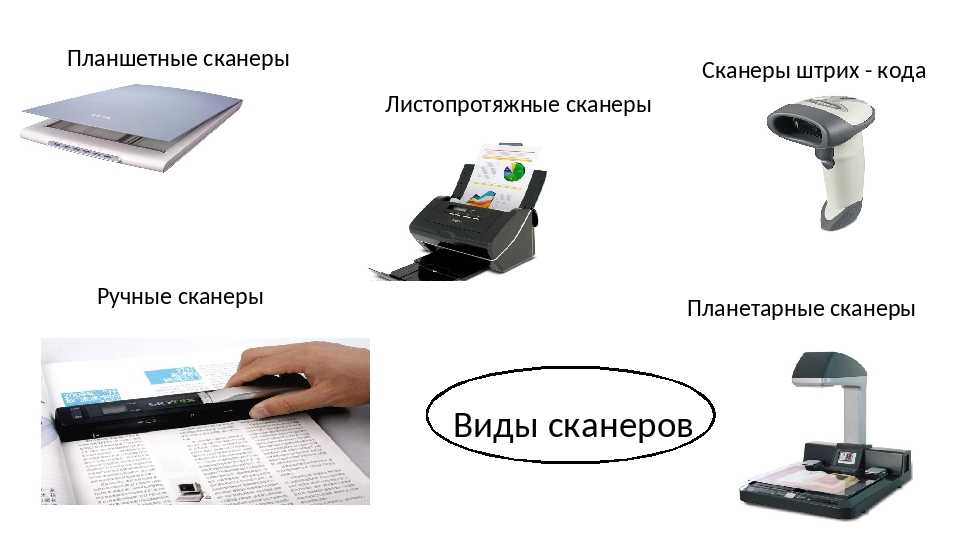

Сканер штрихкодов используется на каждом этапе товародвижения, начиная от комплектации заказа поставщиком, заканчивая выдачей посылки клиенту. Выбор у

20 Апр 2022

14352

- #Сканеры

Обзор сканера штрихкодов Honeywell MS9540: характеристики, инструкция по программированию, драйверы

Honeywell MS9540 — ручной проводной сканер. Распознает все распространенные линейные штрихкоды. Сферы применения: дистрибуция и ретейл;

логист

15 Дек 2021

4578

- #Сканеры

Обзор сканера POScenter HH 2D HD

POScenter HH 2D HD — ручной проводной сканер для считывания всех видов штрихкодов: одномерных и двумерных. Предназначен для торговых точек со средним

8 Дек 2021

3738

- #Сканеры

Считыватель QR-кодов: встречаем COVID-19 во всеоружии

QR-код (англ. Quick Response code) — дословно «код быстрого реагирования». Это двумерный (2D) идентификатор, содержащий данные об объекте, к которому

Quick Response code) — дословно «код быстрого реагирования». Это двумерный (2D) идентификатор, содержащий данные об объекте, к которому

12 мин

30 Ноя 2021

3270

- #Сканеры

Обзор сканера Honeywell MS 5145: характеристики, инструкции, настройка

Honeywell MS 5145 Eclipse — ручной лазерный сканер проводного типа. Распознает только линейные штрихкоды, поэтому не подходит для работы с ЕГАИС и сис

26 Ноя 2021

6762

Подпишитесь на рассылку в один клик.

Одно полезное письмо в неделю. Строго по делу и без спама.

Я принимаю условия передачи информации

- #Все об Эвоторе

- #Сканеры

2 D-сканер для Эвотора: как выбрать и подключить

Мобильные кассы и смарт-терминалы Эвотор ориентированы на малый и средний бизнес. Они компактны, многофункциональны и доступны по цене. По мере необхо

10 мин

27 Окт 2021

19332

- #Сканеры

Беспроводной сканер штрих кода — что это такое

Сканер штрихкода — небольшое торговое устройство с функцией считывания идентификаторов различных символик. «Умеет» распознавать коды, нанесенные на «б

«Умеет» распознавать коды, нанесенные на «б

3 Июн 2021

13134

- #Маркировка товаров

- #Сканеры

Маркировка одежды: какой сканер нужен для совместимости с «Честным ЗНАКом»

Практически все магазины, торгующие блузками, кожаной и верхней одеждой, уже «познакомились» с таким устройством, как сканер для Data Matrix. Для тех,

11 Мар 2021

1836

- #Маркировка товаров

- #Сканеры

- #Услуги

Настройка сканера для «Честного ЗНАКа» — все о сервисе и чуть-чуть о штрихкодах

Сканер штрихкода — простое, но практически незаменимое устройство. В торговле без него как без рук. С внедрением обязательной маркировки товаров выбор

3 Мар 2021

48768

- #Маркировка товаров

- #Сканеры

Топ-5 сканеров для маркировки в 2021 году

К началу 2021 года ряд продовольственных и непродовольственных товаров в России подлежит обязательной маркировке. В основном она проводится с использо

11 Фев 2021

3486

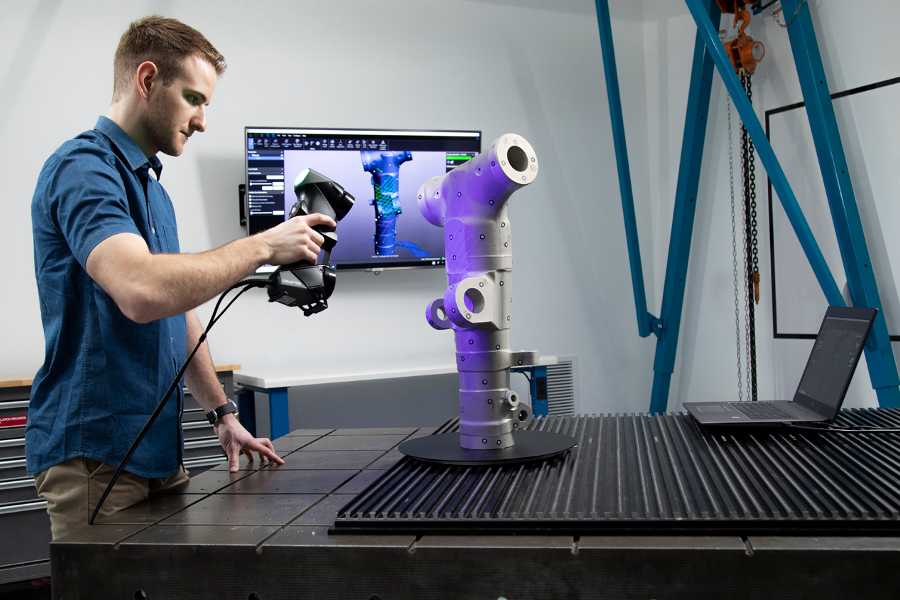

3D-технологии.

Блог iQB technologies. 3D-принтеры и 3D-сканеры профессиональные и промышленные, 3d печать, 3d сканирование, 3d решения в Москве

Блог iQB technologies. 3D-принтеры и 3D-сканеры профессиональные и промышленные, 3d печать, 3d сканирование, 3d решения в Москве

Реверс-инжинирингПрограммное обеспечениеЭксперты рекомендуют

| Время чтения: 7 минут

Как выбрать 3D-сканер

3D-сканерыКонтроль геометрииЛучшее по темам

| Время чтения: 7 минут

Технология селективного лазерного плавления (SLM)

Основы 3DТопологическая оптимизация

| Время чтения: 6 минут

4 задачи реверс-инжиниринга, которые быстро решит 3D‑сканер

Реверс-инжинирингЭксперты рекомендуют

| Время чтения: 6 минут

От воска до металла: обзор основных материалов для 3D-печати

Основы 3DБыстрое прототипирование

| Время чтения: 9 минут

Подготовка данных к 3D‑печати: что делать, когда западный софт недоступен

Программное обеспечениеЭксперты рекомендуют

| Время чтения: 8 минут

3D‑печать в литейном производстве как конкурентное преимущество

Аналитика и бизнесЛитьеЭксперты рекомендуют

| Время чтения: 12 минут

3D‑сканер + фотограмметрия: идеальный контроль качества крупного оборудования

МашиностроениеКонтроль геометрииИстории внедрения

| Время чтения: 5 минут

Подпишитесь на блог

Нажимая на кнопку «Подписаться», вы принимаете условия Политики обработки персональных данных

Что такое геометрические размеры и допуски и почему они важны для производства

Контроль геометрииПрограммное обеспечениеЭксперты рекомендуют

| Время чтения: 7 минут

Краткий гид по применению PETG в 3D‑печати

Основы 3DБыстрое прототипирование

| Время чтения: 6 минут

Быстрее и точнее: самарская компания «Пегас‑Агро» внедряет SLA‑печать

МашиностроениеБыстрое прототипирование3D-принтеры

| Время чтения: 7 минут

Дайджест 3D‑новостей: зима-2023

Лучшее по темам

| Время чтения: 7 минут

Обмер квартиры за 20 минут: создаем цифровую модель с помощью 3D‑сканера

3D-сканерыКонтроль геометрииПрограммное обеспечение

| Время чтения: 8 минут

17 советов по 3D‑печати фотополимерами

Основы 3DБыстрое прототипирование3D-принтеры

| Время чтения: 6 минут

Контроль кривизны труб по данным 3D‑сканирования

Контроль геометрииНефтегазовая отрасль

| Время чтения: 6 минут

Гранулы vs филаменты: снижаем затраты на материалы на 60%

АвтомобилестроениеБыстрое прототипирование3D-принтеры

| Время чтения: 8 минут

<

1

2

3

4

5

. ..

..

40

>

Что такое веб-краулер? (50 слов или меньше)

Когда дело доходит до технического SEO, может быть трудно понять, как все это работает. Но важно получить как можно больше знаний, чтобы оптимизировать наши веб-сайты и охватить более широкую аудиторию. Одним из инструментов, который играет большую роль в поисковой оптимизации, является не что иное, как поисковый робот.

В этом посте мы узнаем, что такое поисковые роботы, как они работают и почему они должны сканировать ваш сайт.

Что такое поисковый робот

Поисковый робот, также известный как веб-паук, — это бот, который ищет и индексирует контент в Интернете. По сути, поисковые роботы отвечают за понимание содержимого веб-страницы, чтобы они могли получить его при запросе.

Вам может быть интересно, «Кто запускает эти поисковые роботы?»

Обычно поисковые системы управляются поисковыми системами с их собственными алгоритмами. Алгоритм сообщает поисковому роботу, как найти релевантную информацию в ответ на поисковый запрос.

Алгоритм сообщает поисковому роботу, как найти релевантную информацию в ответ на поисковый запрос.

Веб-паук будет искать (сканировать) и категоризировать все веб-страницы в Интернете, которые он может найти и должен проиндексировать. Таким образом, вы можете указать веб-сканеру не сканировать вашу веб-страницу, если вы не хотите, чтобы она была найдена в поисковых системах.

Для этого необходимо загрузить файл robots.txt. По сути, файл robots.txt сообщает поисковой системе, как сканировать и индексировать страницы вашего сайта.

Например, давайте посмотрим на Nike.com/robots.txt.

Компания Nike использовала файл robot.txt, чтобы определить, какие ссылки на ее веб-сайте будут просканированы и проиндексированы.

В этой части файла было установлено, что:

- Поисковому роботу Baiduspider было разрешено сканировать первые семь ссылок

- Поисковому роботу Baiduspider запрещено сканировать оставшиеся три ссылки

Это выгодно для Nike, потому что некоторые страницы компании не предназначены для поиска, а запрещенные ссылки не повлияют на ее оптимизированные страницы, которые помогают им ранжироваться в поисковых системах.

Итак, теперь, когда мы знаем, что такое поисковые роботы, как они выполняют свою работу? Ниже рассмотрим, как работают поисковые роботы.

Как работают поисковые роботы?

Поисковый робот работает, обнаруживая URL-адреса, а также просматривая и классифицируя веб-страницы. Попутно они находят гиперссылки на другие веб-страницы и добавляют их в список страниц для последующего сканирования. Поисковые роботы умны и могут определить важность каждой веб-страницы.

Поисковый робот, скорее всего, не просканирует весь Интернет. Скорее, он будет определять важность каждой веб-страницы на основе таких факторов, как количество других страниц, ссылающихся на эту страницу, количество просмотров страниц и даже авторитет бренда. Таким образом, веб-краулер будет определять, какие страницы сканировать, в каком порядке их сканировать и как часто они должны сканировать обновления.

Источник изображения

Например, если у вас есть новая веб-страница или изменения были внесены в существующую страницу, поисковый робот примет это к сведению и обновит индекс. Или, если у вас есть новая веб-страница, вы можете попросить поисковые системы просканировать ваш сайт.

Или, если у вас есть новая веб-страница, вы можете попросить поисковые системы просканировать ваш сайт.

Когда поисковый робот находится на вашей странице, он просматривает копию и метатеги, сохраняет эту информацию и индексирует ее для Google, чтобы отсортировать по ключевым словам.

Прежде чем весь этот процесс будет запущен, веб-сканер просмотрит ваш файл robots.txt, чтобы узнать, какие страницы сканировать, поэтому это так важно для технического SEO.

В конечном счете, когда поисковый робот просматривает вашу страницу, он решает, будет ли ваша страница отображаться на странице результатов поиска по запросу. Важно отметить, что некоторые поисковые роботы могут вести себя иначе, чем другие. Например, некоторые пользователи могут использовать разные факторы при принятии решения о том, какие веб-страницы наиболее важны для сканирования.

Теперь, когда мы рассмотрели, как работают поисковые роботы, мы обсудим, почему они должны сканировать ваш сайт.

Почему сканирование веб-сайтов важно?

Если вы хотите, чтобы ваш сайт занимал высокие позиции в поисковых системах, его необходимо проиндексировать. Без поискового робота ваш веб-сайт не будет найден, даже если вы будете искать более абзаца, взятого непосредственно с вашего веб-сайта.

Без поискового робота ваш веб-сайт не будет найден, даже если вы будете искать более абзаца, взятого непосредственно с вашего веб-сайта.

Проще говоря, ваш веб-сайт не может быть найден естественным путем, если он не просканирован один раз.

Чтобы находить и обнаруживать ссылки в Интернете через поисковые системы, вы должны предоставить своему сайту возможность охватить аудиторию, для которой он предназначен, путем его сканирования, особенно если вы хотите увеличить свой органический трафик.

Если технический аспект сбивает с толку, я понимаю. Вот почему у HubSpot есть курс по оптимизации веб-сайтов, который излагает технические темы простым языком и дает вам инструкции о том, как реализовать свои собственные решения или обсудить их со своим веб-экспертом.

Как и зачем сканировать ваш сайт

Если на вашем сайте есть ошибки, затрудняющие его сканирование, он может упасть ниже в поисковой выдаче. Вы усердно работаете над своим бизнесом и контентом, но, как упоминалось выше, никто не узнает, насколько хорош ваш сайт, если не сможет найти его в Интернете.

К счастью, существуют инструменты для сканирования, такие как Screaming Frog и Deepcrawl, которые могут пролить свет на состояние вашего веб-сайта. Выполнение аудита сайта с помощью инструмента сканирования может помочь вам найти распространенные ошибки и выявить такие проблемы, как:

Неработающие ссылки : Когда ссылки ведут на страницу, которой больше не существует, это не только ухудшает взаимодействие с пользователем, но и может повредить вашему рейтингу в поисковой выдаче.

Дублированный контент : Дублирующийся контент по разным URL-адресам затрудняет для Google (или других поисковых систем) выбор версии, наиболее соответствующей поисковому запросу пользователя. Один из способов исправить это — объединить их с помощью переадресации 301.

Заголовки страниц : Повторяющиеся, отсутствующие, слишком длинные или слишком короткие теги заголовков влияют на рейтинг вашей страницы.

Источник изображения

Вы не сможете устранить проблемы на своем сайте, если не знаете, в чем они заключаются. Использование инструмента веб-сканирования избавляет от догадок при оценке вашего сайта.

Типы инструментов для веб-сканирования

На рынке представлено множество инструментов с различными функциями, но все они делятся на две категории:

Тип используемого вами инструмента зависит от потребностей и бюджета вашей команды. Как правило, выбор облачного варианта позволит расширить возможности совместной работы, поскольку программу не нужно будет хранить на индивидуальном устройстве.

После установки вы можете настроить сканеры на запуск с заданным интервалом и создание отчетов по мере необходимости.

Преимущества использования инструментов веб-сканирования

Правильное сканирование вашего сайта имеет важное значение для SEO. В дополнение к диагностике ошибок сайта преимущества использования инструмента веб-сканирования включают в себя:

1.

Не влияет на производительность сайта

Не влияет на производительность сайта

Поисковые роботы работают в фоновом режиме и не замедляют работу вашего сайта при использовании. Они не будут мешать вашим повседневным задачам и не повлияют на тех, кто просматривает ваш сайт.

2. Встроенная отчетность

Большинство сканеров имеют встроенные функции отчетности или аналитики и позволяют экспортировать эти отчеты в электронную таблицу Excel или другие форматы. Эта функция экономит время и позволяет быстро изучить результаты аудита.

3. Использует автоматизацию

Отличительной особенностью поисковых роботов является то, что вы можете установить частоту сканирования вашего сайта. Это позволяет вам регулярно отслеживать производительность сайта без необходимости каждый раз вручную создавать отчет о сканировании.

Проведение регулярных аудитов сайта с помощью инструмента сканирования — отличный способ убедиться, что ваш сайт находится в хорошем состоянии и ранжируется должным образом.

Расширьте свои возможности с помощью веб-краулинга

Веб-сканеры отвечают за поиск и индексацию контента в Интернете для поисковых систем. Они работают, сортируя и фильтруя веб-страницы, чтобы поисковые системы понимали, о чем каждая веб-страница. Понимание поисковых роботов — это лишь часть эффективного технического SEO, которое может значительно повысить производительность вашего сайта.

Они работают, сортируя и фильтруя веб-страницы, чтобы поисковые системы понимали, о чем каждая веб-страница. Понимание поисковых роботов — это лишь часть эффективного технического SEO, которое может значительно повысить производительность вашего сайта.

Эта статья была первоначально опубликована 15 июля 2021 г. и обновлена для полноты информации.

Поисковые роботы — 10 самых популярных

Бен Итон

Обновлено 16 декабря 2022 г.

Во всемирной паутине есть как плохие, так и хорошие боты. Вы определенно хотите избежать плохих ботов, поскольку они потребляют вашу пропускную способность CDN, занимают ресурсы сервера и крадут ваш контент. С другой стороны, с хорошими ботами (также известными как поисковые роботы) следует обращаться с осторожностью, поскольку они являются жизненно важной частью индексации вашего контента поисковыми системами, такими как Google, Bing и Yahoo. В этом сообщении блога мы рассмотрим десятку самых популярных поисковых роботов.

Что такое поисковые роботы?

Веб-сканеры — это компьютерные программы, которые методично и автоматически просматривают Интернет. Их также называют роботами, муравьями или пауками.

Поисковые роботы посещают веб-сайты и читают их страницы и другую информацию, чтобы создать записи для индекса поисковой системы. Основная цель поискового робота — предоставить пользователям полный и актуальный индекс всего доступного онлайн-контента.

Кроме того, поисковые роботы также могут собирать определенные типы информации с веб-сайтов, например контактную информацию или данные о ценах. Используя поисковые роботы, компании могут поддерживать актуальность и эффективность своего присутствия в Интернете (например, SEO, оптимизация внешнего интерфейса и веб-маркетинг).

Поисковые системы, такие как Google, Bing и Yahoo, используют сканеры для правильного индексирования загруженных страниц, чтобы пользователи могли быстрее и эффективнее находить их при поиске. Без поисковых роботов не было бы ничего, что могло бы сказать им, что на вашем сайте есть новый и свежий контент. Карты сайта также могут играть роль в этом процессе. Так что поисковые роботы, по большей части, это хорошо.

Карты сайта также могут играть роль в этом процессе. Так что поисковые роботы, по большей части, это хорошо.

Однако иногда возникают проблемы с планированием и загрузкой, поскольку поисковый робот может постоянно опрашивать ваш сайт. И здесь в игру вступает файл robots.txt. Этот файл может помочь контролировать сканирующий трафик и гарантировать, что он не перегрузит ваш сервер.

Веб-сканеры идентифицируют себя для веб-сервера с помощью заголовка запроса User-Agent в HTTP-запросе, и каждый сканер имеет свой уникальный идентификатор. В большинстве случаев вам нужно будет просматривать журналы реферера вашего веб-сервера, чтобы просмотреть трафик поискового робота.

Robots.txt

Поместив файл robots.txt в корень вашего веб-сервера, вы можете определить правила для поисковых роботов, например разрешить или запретить сканирование определенных ресурсов. Поисковые роботы должны следовать правилам, определенным в этом файле. Вы можете применить общие правила ко всем ботам или сделать их более детализированными и указать их конкретные User-Agent строка.

Пример 1

Этот пример предписывает всем роботам поисковых систем не индексировать содержимое веб-сайта. Это определяется путем запрета доступа к корневому каталогу / вашего веб-сайта.

Агент пользователя: * Запретить: /

Пример 2

В этом примере достигается противоположность предыдущему. В этом случае инструкции по-прежнему применяются ко всем пользовательским агентам. Однако в инструкции Disallow ничего не определено, а это означает, что все может быть проиндексировано.

Агент пользователя: * Запретить:

Чтобы увидеть больше примеров, обязательно ознакомьтесь с нашим подробным сообщением о том, как использовать файл robots.txt.

10 лучших поисковых роботов и поисковых роботов

Существуют сотни поисковых роботов и поисковых роботов, прочесывающих Интернет, но ниже приведен список из 10 популярных поисковых роботов и поисковых роботов, которые мы собрали на основе тех, которые мы регулярно видим в логи нашего веб-сервера.

1. GoogleBot

Являясь крупнейшей в мире поисковой системой, Google использует поисковые роботы для индексации миллиардов страниц в Интернете. Googlebot — это поисковый робот, который Google использует именно для этого.

Googlebot — это два типа поисковых роботов: настольный поисковый робот, который имитирует человека, просматривающего компьютер, и мобильный поисковый робот, который выполняет те же функции, что и iPhone или телефон Android.

Строка пользовательского агента запроса может помочь вам определить подтип Googlebot. Googlebot Desktop и Googlebot Smartphone, скорее всего, будут сканировать ваш веб-сайт. С другой стороны, оба типа сканеров принимают один и тот же токен продукта (токен пользовательского агента) в файле robots.txt. Вы не можете использовать robots.txt для выборочного таргетинга Googlebot Smartphone или Desktop.

Googlebot — очень эффективный поисковый робот, который может быстро и точно индексировать страницы. Однако у него есть некоторые недостатки. Например, робот Googlebot не всегда сканирует все страницы веб-сайта (особенно если веб-сайт большой и сложный).

Например, робот Googlebot не всегда сканирует все страницы веб-сайта (особенно если веб-сайт большой и сложный).

Кроме того, робот Googlebot не всегда сканирует страницы в режиме реального времени, а это означает, что некоторые страницы могут быть проиндексированы только через несколько дней или недель после их публикации.

Агент пользователя

Googlebot

Полный

User-Agent string

Mozilla/5.0 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html)

Пример робота Googlebot в файле robots.txt

В этом примере несколько более подробно описаны определенные инструкции. Здесь инструкции относятся только к Googlebot. В частности, он говорит Google не индексировать определенную страницу ( /no-index/your-page.html ).

Агент пользователя: Googlebot Запретить: /no-index/your-page.html

Помимо поискового робота Google, у них на самом деле есть 9дополнительные поисковые роботы:

| Поисковый робот | User-Agent string |

|---|---|

| Googlebot News |

9 Googlebot-News 9022 9022 239 Googlebot Images

0

0 Вы можете используйте инструмент Fetch в Google Search Console, чтобы проверить, как Google сканирует или отображает URL-адрес на вашем сайте. Узнайте, может ли робот Googlebot получить доступ к странице на вашем сайте, как он отображает страницу и заблокированы ли какие-либо ресурсы страницы (например, изображения или сценарии) для робота Googlebot.

Узнайте, может ли робот Googlebot получить доступ к странице на вашем сайте, как он отображает страницу и заблокированы ли какие-либо ресурсы страницы (например, изображения или сценарии) для робота Googlebot.

Вы также можете просмотреть статистику сканирования Googlebot за день, количество загруженных килобайт и время, затраченное на загрузку страницы.

См. документацию robots.txt для робота Google.

2. Bingbot

Bingbot — это поисковый робот, развернутый Microsoft в 2010 году для предоставления информации их поисковой системе Bing. Это замена того, что раньше было ботом MSN.

Агент пользователя

Bingbot

Полный

User-Agent string

Mozilla/5.0 (совместимый; Bingbot/2.0; +http://www.bing.com/bingbot.htm)

У Bing также есть инструмент, очень похожий на Google, который называется Fetch as Bingbot в Инструментах для веб-мастеров Bing. Fetch As Bingbot позволяет запросить сканирование страницы и показать ее вам так, как ее увидит наш сканер. Вы увидите код страницы так, как его увидит Bingbot, что поможет вам понять, видят ли они вашу страницу так, как вы предполагали.

Вы увидите код страницы так, как его увидит Bingbot, что поможет вам понять, видят ли они вашу страницу так, как вы предполагали.

См. документацию Bingbot robots.txt.

3. Slurp Bot

Результаты поиска Yahoo поступают от поискового робота Yahoo Slurp и поискового робота Bing, так как большая часть Yahoo работает на базе Bing. Сайты должны разрешать доступ Yahoo Slurp, чтобы они отображались в результатах поиска Yahoo Mobile.

Кроме того, Slurp делает следующее:

- Собирает контент с партнерских сайтов для включения в такие сайты, как Yahoo News, Yahoo Finance и Yahoo Sports.

- Доступ к страницам сайтов в Интернете для подтверждения точности и улучшения персонализированного контента Yahoo для наших пользователей.

Агент пользователя

Slurp

Полный

User-Agent string

Mozilla/5.0 (совместимый; Yahoo! Slurp; http://help.yahoo.com/help/us/ysearch/slurp)

См. документацию Slurp robots.txt.

документацию Slurp robots.txt.

4. DuckDuckBot

DuckDuckBot — это веб-сканер для DuckDuckGo, поисковой системы, которая стала довольно популярной, поскольку известна своей конфиденциальностью и отсутствием слежки за вами. Теперь он обрабатывает более 93 миллионов запросов в день. DuckDuckGo получает результаты из разных источников. К ним относятся сотни вертикальных источников, предоставляющих нишевые мгновенные ответы, DuckDuckBot (их поисковый робот) и краудсорсинговые сайты (Википедия). У них также есть более традиционные ссылки в результатах поиска, которые они получают от Yahoo! и Бинг.

Агент пользователя

DuckDuckBot

Полный

User-Agent строка

DuckDuckBot/1.0; (+http://duckduckgo.com/duckduckbot.html)

Он соответствует WWW::RobotRules и происходит со следующих IP-адресов:

- 72.94.249.34

- 72.94.249.35

- 72.94.249.36

- 72.94.249.38

.7 4

5.

Байдуспайдер

Байдуспайдер

Байдуспайдер — это официальное название паука китайской поисковой системы Baidu. Он сканирует веб-страницы и возвращает обновления в индекс Baidu. Baidu — ведущая китайская поисковая система, на долю которой приходится 80% всего рынка поисковых систем материкового Китая.

Агент пользователя

Baiduspider

Полный

User-Agent string

Mozilla/5.0 (совместимый; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

Помимо поискового робота Baidu, у них есть еще 6 поисковых роботов:

| Поисковый робот | User-Agent string | 9 Image Search Baiduspider-образ |

|---|---|

| Поиск видео | Baiduspider-video |

| Поиск новостей | Baiduspider-новости |

| Списки желаний Baidu | Baiduspider-favo 3292 | Baiduspider-cpro |

| Поиск по бизнесу | Baiduspider -ads |

| Другие страницы поиска | Baiduspider |

См. документацию Baidu robots.txt.

документацию Baidu robots.txt.

6. Яндекс Бот

ЯндексБот — поисковый робот для одной из крупнейших российских поисковых систем Яндекс.

User-Agent

ЯндексБот

Full

User-Agent string

Mozilla/5.0 (совместимый; YandexBot/3.0; +http://yandex.com/bots)

Существует множество различных строк User-Agent, которые ЯндексБот может отображать в логах вашего сервера.

7. Sogou Spider

Sogou Spider — поисковый робот для Sogou.com, ведущей китайской поисковой системы, запущенной в 2004 году.

Примечание: Веб-паук Sogou не соблюдает стандарт исключения роботов и поэтому запрещен на многих веб-сайтах из-за чрезмерного сканирования.

User-Agent

Sogou Pic Spider/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Головной паук Sogou/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Веб-паук Sogou/4.0 (+http://www.sogou.com/docs/help/webmasters.htm#07) Паук Sogou Orion/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Sogou-Test-Spider/4.0 (совместимый; MSIE 5.5; Windows 98)

8. Exabot

Exabot — поисковый робот для Exalead, поисковой системы, базирующейся во Франции. Он был основан в 2000 году и имеет более 16 миллиардов проиндексированных страниц.

User-Agent

Mozilla/5.0 (совместимый; Konqueror/3.5; Linux) KHTML/3.5.5 (как Gecko) (Exabot-Thumbnails) Mozilla/5.0 (совместимо; Exabot/3.0; +http://www.exabot.com/go/robot)

См. документацию Exabot robots.txt.

9. Facebook external hit

Facebook позволяет своим пользователям отправлять ссылки на интересный веб-контент другим пользователям Facebook. Часть того, как это работает в системе Facebook, включает временное отображение определенных изображений или деталей, связанных с веб-контентом, таких как название веб-страницы или встроенный тег видео. Система Facebook извлекает эту информацию только после того, как пользователь предоставит ссылку.

Одним из их основных сканирующих ботов является Facebot, предназначенный для повышения эффективности рекламы.

User-Agent

фейсбот facebookexternalhit/1.0 (+http://www.facebook.com/externalhit_uatext.php) facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)

См. документацию Facebot robots.txt.

10. Applebot

Бренд компьютерных технологий Apple использует поисковый робот Applebot, в частности Siri и Spotlight Suggestions, для предоставления персонализированных услуг своим пользователям.

Агент пользователя

Applebot

Full

User-Agent string

Mozilla/5.0 (Device; OS_version) AppleWebKit/WebKit_version (KHTML, как Gecko) Версия/Safari_версия Safari/WebKit_версия (Applebot/Applebot_version)

Другие популярные поисковые роботы

Apache Nutch

Apache Nutch — поисковый робот с открытым исходным кодом, написанный на Java. Он выпущен под лицензией Apache и управляется Apache Software Foundation.

Он выпущен под лицензией Apache и управляется Apache Software Foundation.

Nutch может работать на одной машине, но чаще используется в распределенной среде. На самом деле, Nutch был разработан с нуля, чтобы быть масштабируемым и легко расширяемым.

Орех очень гибкий и может использоваться для различных целей. Например, Nutch можно использовать для обхода всего Интернета или только определенных веб-сайтов. Кроме того, Nutch можно настроить на индексацию страниц в режиме реального времени или по расписанию.

Одним из основных преимуществ Apache Nutch является его масштабируемость. Nutch можно легко масштабировать для обработки больших объемов данных и трафика. Например, большой веб-сайт электронной коммерции может использовать Apache Nutch для сканирования и индексации своего каталога продуктов. Это позволит клиентам искать продукты на своем веб-сайте с помощью внутренней поисковой системы компании.

Кроме того, Apache Nutch можно использовать для сбора данных о веб-сайтах. Компании могут использовать Apache Nutch для сканирования веб-сайтов конкурентов и сбора информации об их продуктах, ценах и контактной информации. Затем эта информация может быть использована для улучшения их присутствия в Интернете.

Компании могут использовать Apache Nutch для сканирования веб-сайтов конкурентов и сбора информации об их продуктах, ценах и контактной информации. Затем эта информация может быть использована для улучшения их присутствия в Интернете.

Однако у Apache Nutch есть некоторые недостатки. Например, это может быть сложно настроить и использовать. Кроме того, Apache Nutch не так широко используется, как другие поисковые роботы, а это означает, что для него доступна меньшая поддержка.

Screaming Frog

Screaming Frog SEO Spider — это настольная программа (ПК или Mac), которая сканирует ссылки, изображения, CSS, скрипты и приложения веб-сайтов с точки зрения SEO.

Он извлекает ключевые элементы сайта для SEO, представляет их на вкладках по типам и позволяет вам фильтровать общие проблемы SEO или нарезать данные так, как вам нравится, экспортируя их в Excel.

Вы можете просматривать, анализировать и фильтровать данные сканирования по мере их сбора и извлечения в режиме реального времени с помощью простого интерфейса.

Программа бесплатна для небольших сайтов (до 500 URL). Для больших сайтов требуется лицензия.

Screaming Frog использует Chromium WRS для сканирования динамических веб-сайтов с большим количеством JavaScript, таких как Angular, React и Vue.js. Создание карты сайта WordPress, извлечение XPath и визуализация архитектуры сайта — другие важные функции.

Платформа обслуживает такие корпорации, как Apple, Amazon, Disney и даже Google. Screaming Frog также является популярным инструментом среди владельцев агентств и SEO-специалистов, которые управляют SEO для нескольких клиентов.

Deepcrawl

Deepcrawl — это облачный поисковый робот, который позволяет пользователям сканировать веб-сайты и собирать данные об их структуре, содержании и производительности.

DeepCrawl предоставляет пользователям несколько функций и опций, включая возможность сканирования веб-сайтов на основе JavaScript, настройку процесса сканирования и создание подробных отчетов.

Одной из самых уникальных функций Deepcrawl является его способность сканировать веб-сайты, созданные с помощью JavaScript. Это возможно, потому что Deepcrawl использует безголовый браузер (например, Chrome) для отображения содержимого веб-сайта перед его сканированием.

Это означает, что Deepcrawl может сканировать и собирать данные о веб-сайтах, которые не всегда могут быть доступны другим поисковым роботам.

Помимо гибких API, данные Deepcrawl интегрируются с Google Analytics, Google Search Console и другими популярными инструментами. Это позволяет пользователям легко сравнивать данные своего веб-сайта с данными конкурентов. Это также позволяет им связывать бизнес-данные (например, данные о продажах) с данными своего веб-сайта, чтобы получить полное представление о том, как работает их веб-сайт.

Deepcrawl лучше всего подходит для компаний с большими веб-сайтами с большим количеством контента и страниц. Платформа менее подходит для небольших веб-сайтов или тех, которые не меняются очень часто.

Deepcrawl предлагает три разных продукта:

- Центр автоматизации: этот продукт интегрируется с конвейером CI/CD и автоматически сканирует ваш веб-сайт с более чем 200 правилами тестирования SEO QA.

- Центр аналитики: Этот продукт позволяет вам получать полезную информацию из данных вашего веб-сайта и улучшать SEO вашего веб-сайта.

- Концентратор мониторинга: этот продукт отслеживает изменения на вашем веб-сайте и предупреждает вас о появлении новых проблем.

Компании используют эти три продукта для улучшения SEO своего веб-сайта, отслеживания изменений и сотрудничества с командами разработчиков.

Octoparse

Octoparse — это удобное клиентское программное обеспечение для сканирования веб-страниц, которое позволяет извлекать данные со всего Интернета. Программа специально разработана для людей, не являющихся программистами, и имеет простой интерфейс «укажи и щелкни».

С помощью Octoparse вы можете запускать запланированные облачные извлечения для извлечения динамических данных, создавать рабочие процессы для автоматического извлечения данных с веб-сайтов и использовать его API парсинга веб-страниц для доступа к данным.

Его прокси-серверы IP позволяют сканировать веб-сайты без блокировки, а встроенная функция Regex автоматически очищает данные.

Благодаря готовым шаблонам скрейпера вы можете начать извлекать данные с популярных веб-сайтов, таких как Yelp, Google Maps, Facebook и Amazon, за считанные минуты. Вы также можете создать свой собственный парсер, если его нет в наличии для ваших целевых веб-сайтов.

HTTrack

Вы можете использовать бесплатное ПО HTTrack для загрузки целых сайтов на свой компьютер. Благодаря поддержке Windows, Linux и других систем Unix этот инструмент с открытым исходным кодом может использоваться миллионами.

Средство копирования веб-сайтов HTTrack позволяет загружать веб-сайты на компьютер, чтобы вы могли просматривать их в автономном режиме. Программу также можно использовать для зеркалирования веб-сайтов, что означает, что вы можете создать точную копию веб-сайта на своем сервере.

Программа проста в использовании и имеет множество функций, в том числе возможность возобновлять прерванные загрузки, обновлять существующие веб-сайты и создавать статические копии динамических веб-сайтов.

Вы можете получить файлы, фотографии и HTML-код с зеркального веб-сайта и возобновить прерванную загрузку.

Хотя HTTrack можно использовать для загрузки веб-сайтов любого типа, он особенно полезен для загрузки веб-сайтов, которые больше не доступны в сети.

HTTrack — отличный инструмент для тех, кто хочет загрузить весь веб-сайт или создать его зеркальную копию. Однако следует отметить, что программу можно использовать для загрузки нелегальных копий веб-сайтов.

Таким образом, вы должны использовать HTTrack только в том случае, если у вас есть разрешение от владельца веб-сайта.

SiteSucker

SiteSucker — это приложение для macOS, которое загружает веб-сайты. Он асинхронно копирует веб-страницы сайта, изображения, PDF-файлы, таблицы стилей и другие файлы на ваш локальный жесткий диск, дублируя структуру каталогов сайта.

Вы также можете использовать SiteSucker для загрузки определенных файлов с веб-сайтов, таких как файлы MP3.

Программа может использоваться для создания локальных копий веб-сайтов, что делает ее идеальной для просмотра в автономном режиме.

Это также полезно для загрузки целых сайтов, чтобы вы могли просматривать их на своем компьютере без подключения к Интернету.

Одним из недостатков SiteSucker является то, что он не может обрабатывать Javascript (хотя может обрабатывать Flash). Тем не менее, он по-прежнему полезен для загрузки веб-сайтов на ваш Mac.

Webz.io

Пользователи могут использовать веб-приложение Webz.io для получения данных в режиме реального времени путем сканирования онлайн-источников по всему миру в различных удобных форматах. Этот поисковый робот позволяет сканировать данные и извлекать ключевые слова на нескольких языках на основе многочисленных критериев из различных источников.

Архив позволяет пользователям получать доступ к историческим данным. Пользователи могут легко индексировать и искать структурированные данные, просканированные Webhose, используя его интуитивно понятный интерфейс/API. Вы можете сохранять очищенные данные в форматах JSON, XML и RSS. Кроме того, Webz. io поддерживает до 80 языков с результатами сканирования данных.

io поддерживает до 80 языков с результатами сканирования данных.

Freemium бизнес-модель Webz.io должна подойти для предприятий с базовыми требованиями к сканированию. Для предприятий, которым требуется более надежное решение, Webz.io также предлагает поддержку мониторинга СМИ, угроз кибербезопасности, анализа рисков, финансового анализа, веб-аналитики и защиты от кражи личных данных.

Они даже поддерживают решения API даркнета для бизнес-аналитики.

UiPath

UiPath — это приложение Windows, которое можно использовать для автоматизации повторяющихся задач. Это полезно для парсинга веб-страниц, поскольку оно может автоматически извлекать данные с веб-сайтов.

Программа проста в использовании и не требует знаний в области программирования. Он имеет визуальный интерфейс перетаскивания, который упрощает создание сценариев автоматизации.

С помощью UiPath вы можете извлекать табличные данные и данные на основе шаблонов с веб-сайтов, PDF-файлов и других источников. Программу также можно использовать для автоматизации таких задач, как заполнение онлайн-форм и загрузка файлов.

Программу также можно использовать для автоматизации таких задач, как заполнение онлайн-форм и загрузка файлов.

Коммерческая версия инструмента предоставляет дополнительные возможности сканирования. При работе со сложными пользовательскими интерфейсами этот подход очень успешен. Инструмент очистки экрана может извлекать данные из таблиц как по отдельным словам, так и по группам текста, а также по блокам текста, таким как RSS-каналы.

Кроме того, вам не нужны навыки программирования для создания интеллектуальных веб-агентов, но если вы хакер .NET, вы сможете полностью контролировать их данные.

Плохие боты

Хотя большинство поисковых роботов безопасны, некоторые из них могут использоваться в злонамеренных целях. Эти вредоносные веб-сканеры, или «боты», могут использоваться для кражи информации, проведения атак и совершения мошенничества. Также все чаще обнаруживается, что эти боты игнорируют директивы robots.txt и переходят непосредственно к сканированию веб-сайтов.

Ниже перечислены некоторые известные вредоносные боты:

- PetalBot

- SEMrushBot

- Majestic

- DotBot

- AhrefsBot

9000 сканирование вашего веб-сайта

Чтобы защитить свой сайт от вредоносных ботов, вы можете использовать брандмауэр веб-приложений (WAF) для защиты вашего сайта от ботов и других угроз. WAF — это часть программного обеспечения, которое находится между вашим веб-сайтом и Интернетом и фильтрует трафик до того, как он попадет на ваш сайт.

CDN также может помочь защитить ваш сайт от ботов. CDN — это сеть серверов, которые доставляют контент пользователям в зависимости от их географического положения.

Когда пользователь запрашивает страницу с вашего веб-сайта, CDN направляет запрос на сервер, ближайший к местоположению пользователя. Это может помочь снизить риск атаки ботов на ваш сайт, поскольку им придется нацеливаться на каждый сервер CDN в отдельности.

У KeyCDN есть отличная функция, которую вы можете включить на своей панели инструментов, которая называется «Блокировка плохих ботов».

Всего комментариев: 0